数学建模社区-数学中国

标题: 爬虫(六十九)简明 jieba 中文分词教程(六十) [打印本页]

作者: 杨利霞 时间: 2020-5-31 10:40

标题: 爬虫(六十九)简明 jieba 中文分词教程(六十)

爬虫(六十九)简明 jieba 中文分词教程(六十) w/ m2 H% j5 R7 C$ S j$ ^

" c# q1 ]. H h8 ~; H0 引言jieba 是目前最好的 Python 中文分词组件,它主要有以下 3 种特性:

- 1 [/ V4 T8 E7 c& R. t

$ L3 y. k$ l6 f2 U% z# 导入 jieba

9 K! x- C' y3 D8 m* {) n

5 E6 R. L1 ~& C8 S

% e& }9 v+ O4 y3 e& H: T

1 W3 @+ S5 ~' U) H, g" |import jieba! W$ A+ a1 n- O) c+ G; |! u

/ d4 i% }/ w) t4 D! q( J8 a7 e0 y

l$ L+ k9 _: l0 U+ t; w: j' k0 ^- U+ { Y. I4 s) ^

import jieba.posseg as pseg #词性标注

+ D) V8 X' b' {; l6 L, K h& c- }/ a# M5 V

- 1 x* P' ]3 h) J! S+ U& ^7 @" O, o, A: R3 R

* r) Q0 Y! W0 b/ H: C6 a

import jieba.analyse as anls #关键词提取

9 C( w: h4 J& [8 f

7 o, e' N# @' s* n; I# W/ o, G! d: w H# U# L: f

1 分词% r& z, o( C, ]! T( k5 z1 X1 Z

可使用 jieba.cut 和 jieba.cut_for_search 方法进行分词,两者所返回的结构都是一个可迭代的 generator,可使用 for 循环来获得分词后得到的每一个词语(unicode),或者直接使用 jieba.lcut 以及 jieba.lcut_for_search 直接返回 list。其中:. C* O$ H: h$ Q

# 尽量不要使用 GBK 字符串,可能无法预料地错误解码成 UTF-8

/ Q; I/ K& _1 C j2 G. Y$ F; z1.1 全模式和精确模式1 c; Q+ z/ h+ v

% T8 n4 ~6 c, s* t6 w

2 k! V {6 l. t+ N/ Y5 U; k3 j

5 q! I0 c' ]( I: i( k' |7 ^, ^2 D7 s+ A. y# 全模式9 H' l9 c8 T, ?2 R/ W" }" T

0 N1 T# {6 B% L9 u9 X6 c& J

$ g* V/ I$ z- r2 o4 ^% x1 e# g2 J: c. N/ ?8 ]% U: W7 N

seg_list = jieba.cut("他来到上海交通大学", cut_all=True)$ h% s+ c3 X) z9 Q

1 ^% K% W" l) O, ^: d

- ' z. m3 z9 D( ]+ l' M: l* X7 t

- A; |3 E2 O) v( o0 f7 V$ R _3 [print("【全模式】:" + "/ ".join(seg_list))

! F* M; `5 A8 T# f5 E

* U" D% ?/ Z# V8 E4 G

( w: }; j7 M) Q$ p

【全模式】:他/ 来到/ 上海/ 上海交通大学/ 交通/ 大学

. J. o% F6 W! {, x. U; @! `

{' E8 W: K. ^, q; E# 精确模式+ z1 J! j+ X0 }# h$ x b

! ]% I! J6 k* \' x0 `& J

2 d. H. D% u) @, U& ?

2 k" g' \4 e9 o, X+ ^seg_list = jieba.cut("他来到上海交通大学", cut_all=False)

- @9 l2 k& W& O7 [0 G9 z, i- a3 p

- % t$ ]8 o+ n- U; I

0 R9 G$ V! r) y8 m6 w5 G/ Kprint("【精确模式】:" + "/ ".join(seg_list))+ L8 `# G9 G+ o+ |3 A5 R

# F! c3 t$ q8 K2 d- y5 A3 Q1 [9 G1 ~1 J! c( }; D

【精确模式】:他/ 来到/ 上海交通大学

type(seg_list)generator

. m0 F8 s- a H6 a1 y9 Y# |; d% k$ T" M" ?) H! K$ Q

# 返回列表 @5 }% I- j* k4 R; r

0 q2 y3 @+ b% x+ [; o, e

: j! w4 g: y R# z9 v/ o7 j3 m& e" Z$ S& P6 A ?5 k

seg_list = jieba.lcut("他来到上海交通大学", cut_all=True)( c. O+ K/ T$ p! C: w$ s7 A: y

% A, o' Y3 i# M; u

Q; ]3 G: d/ a. E: f* p9 {/ Q; ^5 A, C; T% V7 b6 [0 {" _: ?

print("【返回列表】:{0}".format(seg_list)). D5 r) \7 p. w, ^1 u2 ?

; w" P0 h/ r8 T% W, s3 O

3 X: j, w2 p. D' @

【返回列表】:['他', '来到', '上海', '上海交通大学', '交通', '大学']

type(seg_list)list

1.2 搜索引擎模式

- ) [" S" O6 x) a) G& I

; c; Z# I2 |1 j2 d% M) N

# 搜索引擎模式. B7 C0 Y1 H0 }0 j0 j* a

" B6 y# @; @% s

- ! ^- B: ?& _1 |" N( b i

8 p; n) a! {' ?" M4 r% L" x

seg_list = jieba.cut_for_search("他毕业于上海交通大学机电系,后来在一机部上海电器科学研究所工作")' C5 d" D; Q* }! X: ?1 {

, z! c$ e8 {' \7 W+ O

3 h6 L8 `0 A$ o% T+ J+ Q. d) x

% |; u. Z8 n' c; c8 Mprint("【搜索引擎模式】:" + "/ ".join(seg_list))5 E1 g/ r( q, M8 f+ F7 _: m

7 R2 }# X1 G9 P

" q& | M3 G5 B: y

【搜索引擎模式】:他/ 毕业/ 于/ 上海/ 交通/ 大学/ 上海交通大学/ 机电/ 系/ ,/ 后来/ 在/ 一机部/ 上海/ 电器/ 科学/ 研究/ 研究所/ 工作

5 }; W* K2 ]. g! R0 E: d" b

& B4 ~/ H/ |8 Q# 返回列表' ]- U! g$ q7 v, E8 P7 x2 [2 C

, B- D* U7 o# j$ b/ b

, ~7 Y7 D/ s6 a& ]1 D# \( A% \9 d2 k* S; `

seg_list = jieba.lcut_for_search("他毕业于上海交通大学机电系,后来在一机部上海电器科学研究所工作")

+ {* T9 Q7 ] i/ A' U5 }# E6 } Q2 S2 g

" ]) J2 B8 ?6 @1 Z; ]2 G4 d* t5 D {3 L( x" n" k: I

print("【返回列表】:{0}".format(seg_list))

" `: b0 v/ G. \0 Z9 ?, {" m ~; M% d

: A( I! M1 X! \) V9 A' r0 L& I

【返回列表】:['他', '毕业', '于', '上海', '交通', '大学', '上海交通大学', '机电', '系', ',', '后来', '在', '一机部', '上海', '电器', '科学', '研究', '研究所', '工作']

9 d! `) |8 S; ?4 b. n6 M3 l9 y1 N- h. b2 ]/ z5 L

1.3 HMM 模型, w- \7 `2 c, R& S

HMM 模型,即隐马尔可夫模型(Hidden Markov Model, HMM),是一种基于概率的统计分析模型,用来描述一个系统隐性状态的转移和隐性状态的表现概率。在 jieba 中,对于未登录到词库的词,使用了基于汉字成词能力的 HMM 模型和 Viterbi 算法,其大致原理是:' @: [& f( Q- U$ T0 t/ T4 h% ^

采用四个隐含状态,分别表示为单字成词,词组的开头,词组的中间,词组的结尾。通过标注好的分词训练集,可以得到 HMM 的各个参数,然后使用 Viterbi 算法来解释测试集,得到分词结果。

' T' }5 E2 Z) C( u1 D# F+ V+ y/ F2 Q' Z

# 代码实现可参考 HmmSeg.py% f: j D3 w. |% o6 X! Q

3 z- A' o; ^, g

G! j. D. a2 `( b* S

7 i. m/ N, r! g" x& U% G# 未启用 HMM

* F7 z) s, ]7 F

1 x1 c2 X% ~, S( A* D+ o( _- % |# }& X, d: w, {- V

4 j2 w! k6 D) R1 S7 B+ m

seg_list = jieba.cut("他来到了网易杭研大厦", HMM=False) #默认精确模式和启用 HMM5 d8 y. ~! w4 y! y3 w, G

) l! G5 \( I- ]! h; |% l/ } - + m. X/ H; d$ o3 W5 Y+ R' t

. D9 ?0 G u1 Z' `print("【未启用 HMM】:" + "/ ".join(seg_list))

8 p0 X) W7 Z2 S- H* m2 L& {7 B& ~* C0 I, n) f( G/ A

2 F2 s$ M# b5 r& t; s, J& m

【未启用 HMM】:他/ 来到/ 了/ 网易/ 杭/ 研/ 大厦

- # Z9 D0 g! _2 w+ D2 i

7 i7 U7 ]: k+ B. I3 E( o

# 识别新词; q: T/ o* J. d

1 N B* Z* R4 E9 e. o5 L6 s

- % L6 _3 X Z9 }& l# D

# @9 f6 D- Y. Lseg_list = jieba.cut("他来到了网易杭研大厦") #默认精确模式和启用 HMM8 L5 B# U! ^5 a% M

D/ p& x! w# ~1 Z+ R( N

% P- a- D9 h! `: v0 P, I

$ K) @. T% S7 E/ iprint("【识别新词】:" + "/ ".join(seg_list))

3 m, I3 N, z+ C/ z+ {" Z! o2 y1 Y9 \ P+ h$ t( G

- N! K0 F- P* N8 c+ s. o6 Z8 @1 e

【识别新词】:他/ 来到/ 了/ 网易/ 杭研/ 大厦

2 繁体字分词jieba 还支持对繁体字进行分词。

! X" @- n- ]& K9 T8 T! c8 ~: V5 Q2 @3 i

# 繁体字文本- M6 U% ^! _, U" H, r- @0 |

; W& a# D5 y D; y4 ~! G& z0 e

8 \) Y2 O8 X& ]4 q8 C1 N$ u' s& W& s% v" l2 f2 B9 h9 m! t

ft_text = """人生易老天難老 歲歲重陽 今又重陽 戰地黃花分外香 壹年壹度秋風勁 不似春光 勝似春光 寥廓江天萬裏霜 """; z" V% H+ H* R6 m" j

6 t: ^5 }) i" G% p F

- 2 ?! t/ ]" _. E+ d! U5 K6 j

& i5 n0 X7 d% r/ j. x; ~1 F0 t# 全模式0 ?3 E4 D4 n) K/ z+ Y: N

$ b! b2 `& x) d! v+ U

- ! x% J( E. u y

?8 H9 O3 k: F! t3 P% i

print("【全模式】:" + "/ ".join(jieba.cut(ft_text, cut_all=True)))

5 V9 {: X( O! P) O. u3 ?, Z0 |' ^, u. c& w" R& D

1 d$ N R0 `( O' e- \) Z

【全模式】:人生/ 易/ 老天/ 難/ 老/ / / 歲/ 歲/ 重/ 陽/ / / 今/ 又/ 重/ 陽/ / / 戰/ 地/ 黃/ 花/ 分外/ 香/ / / 壹年/ 壹/ 度/ 秋/ 風/ 勁/ / / 不似/ 春光/ / / 勝/ 似/ 春光/ / / 寥廓/ 江天/ 萬/ 裏/ 霜/ /

/ J. V! j) ]% X, O+ C) V

- 1 x. B/ j. s7 n4 P5 ?5 o- B

! E) H! p# [/ W) R7 a

# 精确模式

) e0 M. ^, g7 F! H1 Z4 Y% m5 a: x* V& P* B) {% i0 ]) ?

- - X$ F. ~/ a2 L8 x! j( F2 H

; ]5 i m" U) C% y1 ^2 `. @

print("【精确模式】:" + "/ ".join(jieba.cut(ft_text, cut_all=False))). K; E5 s) H2 L0 ~2 p' S

" W" z% \: i4 ^

) ]' _& a' i. G$ y

【精确模式】:人生/ 易/ 老天/ 難老/ / 歲/ 歲/ 重陽/ / 今/ 又/ 重陽/ / 戰地/ 黃/ 花/ 分外/ 香/ / 壹年/ 壹度/ 秋風勁/ / 不/ 似/ 春光/ / 勝似/ 春光/ / 寥廓/ 江天/ 萬/ 裏/ 霜/( e7 p( d$ z. m3 @

7 A0 P: C0 [4 e! s! x# j0 h

1 `% o3 p( B, R" t7 v( J- y; B* E$ q

% _6 c$ }/ u! G+ r. w

7 T( |! Z, x0 Z$ d. D# 搜索引擎模式

! L4 |0 P1 I, S3 [

9 c6 q, w7 S( A, _

4 w* S) a7 w/ [7 H/ I2 H7 n: T5 u1 i% q

print("【搜索引擎模式】:" + "/ ".join(jieba.cut_for_search(ft_text)))7 ^: |* X' Y; w" [" X' ?9 Q

. z9 j; m5 ?1 k, S$ A

4 y8 S' X: o6 s- |, O: r1 ]9 b

搜索引擎模式】:人生/ 易/ 老天/ 難老/ / 歲/ 歲/ 重陽/ / 今/ 又/ 重陽/ / 戰地/ 黃/ 花/ 分外/ 香/ / 壹年/ 壹度/ 秋風勁/ / 不/ 似/ 春光/ / 勝似/ 春光/ / 寥廓/ 江天/ 萬/ 裏/ 霜/

?! W* ~. D* J9 n% q" M! ^5 F" u. u6 V: b- s. c% _0 Y

3 添加自定义词典; f, c5 h8 h9 t R4 |, p/ ^! u

开发者可以指定自定义词典,以便包含 jieba 词库里没有的词,词典格式如下:! v# L4 o/ z# T- F

词语 词频(可省略) 词性(可省略)8 Q% _) e+ Y' ~5 k

J5 `; l$ p6 B. J* i5 a/ f

例如:

4 e" I5 j2 h9 E S, y! M2 S5 D( `# t' L

* R/ L& E2 v7 l( H% b3 }

& ?# W7 A9 j+ d8 W/ t6 W: T/ s2 R. \* L/ |* u6 a7 a

创新办 3 i, ~3 _ v: A- K* R L

8 z! r# {' H- B, k' s. j+ e: W

1 n r R" |" w* r) l

+ F3 K9 ?$ w+ g* S云计算 5

+ {* X* @7 G& \* }) u4 O5 r; \, y- G

- # k2 x# c& i/ Z+ k0 \ B3 _ U

: O h1 e+ _- h# W. m. G5 T0 _

凱特琳 nz

; }( l' f+ G2 R7 n. ^; C; ]0 m2 v

4 C Z/ n7 x4 }+ M: I$ Y6 o: A. h0 `7 b. M }) e

# 虽然 jieba 有新词识别能力,但自行添加新词可以保证更高的正确率。# k# d# M; I4 N+ E% u

3.1 载入词典

6 l4 `0 [5 \4 L% S0 Y) d( u4 a% ^2 i使用 jieba.load_userdict(file_name) 即可载入词典。

: ^5 I8 P- X: P1 U# file_name 为文件类对象或自定义词典的路径' n' w E; Y( q* W, S% n$ A0 {

% n% B3 ]7 Q( H5 k* i8 |) l' f( m4 M$ e; Q4 g

- ( \( L2 Y4 B& t/ |# q

! k6 y- W) O( R

# 示例文本' w6 d \9 }$ I E

$ U6 M: g5 q' A* k4 g

- ' O* D! N3 i/ \3 a. A7 Q% [ p* W4 S

/ E5 b$ d: }" N$ [

sample_text = "周大福是创新办主任也是云计算方面的专家"

" K6 l, x# j" v. |& C

- F# E' {$ s" q

3 j! c+ _4 D3 ~9 _* e: x& [

) m* {9 p# e, X

3 p/ @! W8 C; G7 u: R+ y& t2 e0 A# Z/ `3 g+ b

* J6 ~ N& }! n

1 l1 q3 G* X2 a1 D! T3 `# 未加载词典

/ Y0 h' n( q+ q& V

* n$ E6 F( x& l# S2 K# {! Y- * B# j6 ?! j+ q2 s

) O" Z" N& r4 p

print("【未加载词典】:" + '/ '.join(jieba.cut(sample_text)))

9 ?% j% U. ]" A4 _* O1 S

) e5 _0 {, Z' o- E3 m

" I) I" ]. J, Z$ c; c

【未加载词典】:周大福/ 是/ 创新/ 办/ 主任/ 也/ 是/ 云/ 计算/ 方面/ 的/ 专家

【加载词典后】:周大福/ 是/ 创新办/ 主任/ 也/ 是/ 云计算/ 方面/ 的/ 专家

2 |: w! y C; |3 N) i8 z# i( d6 j! P% g1 s8 y/ r5 @$ S

3.2 调整词典

- z6 L q0 v6 ]( C5 D6 R8 D' L* I! M使用 add_word(word, freq=None, tag=None) 和 del_word(word) 可在程序中动态修改词典。! }- M0 T# v Y; B

* s# T; A0 F6 E# N3 G! n+ Y5 d" w! z7 i

! U3 O6 \- E% I6 [

5 \* j% U( K9 o5 ?, ~. Djieba.add_word('石墨烯') #增加自定义词语

3 e$ U/ r3 P7 x7 Q( Z5 n0 f1 r4 M0 s5 v; P" I2 h8 U3 e: P+ S$ f

- 1 j6 h/ A/ {' [

% b) ^& U- U. l/ V! {2 I/ Jjieba.add_word('凱特琳', freq=42, tag='nz') #设置词频和词性( h! r7 ~5 h1 a! p; l4 ]

3 @" s3 R; Q; v2 O0 H

& e2 ~% M5 A2 \0 Y4 E4 I+ f% u$ v" q( V* w5 r% G

jieba.del_word('自定义词') #删除自定义词语

, ]# d) B# D% k" u0 x; m F; ?" Y5 K

( | h, [$ e4 ]: W

使用suggest_freq(segment, tune=True)可调节单个词语的词频,使其能(或不能)被分出来

; `/ O" n0 F- \, {, A/ A- i+ {$ ?! _: _1 D

# 调节词频前) Y! _6 {. V6 p: ?* ]& q3 Z

% W" q9 U9 X1 [" h2 k; r i

- 1 S3 b0 S# q) q; I

% T) L/ M1 C# D: f0 g4 Q6 Bprint("【调节词频前】:" + '/'.join(jieba.cut('如果放到post中将出错。', HMM=False)))' g/ f4 o- x$ a( I

3 f: V, d2 N5 U2 x \; P4 B% d% {$ x0 y

【调节词频前】:如果/放到/post/中将/出错/。

& j4 K; c: A% l. E

% m( R! `( d8 O/ ~' H: }1 ?( z# 调节词频

$ M" A# c+ Y1 [8 S( l7 Y- I( F8 \; h! W9 ^1 O$ ~ w2 Q

7 z v+ ^0 N+ U( @+ k5 o2 D( S t

jieba.suggest_freq(('中', '将'), True)5 l/ J3 t1 U1 d# c' \

# ?0 w! L5 E" [/ S2 |

+ l4 \2 }+ O6 _: o5 s, A \

494

3 S: r/ P, K5 Y2 d2 u# l9 d& s6 B& j: b! H9 b# p

# 调节词频后0 v* P# i+ i8 E6 c, U

+ t, ^& e. ~ j6 I- 0 y! U; g0 W. L: y( _0 |0 B

4 J" n; R, q# ~4 b# I: P

print("【调节词频后】:" + '/'.join(jieba.cut('如果放到post中将出错。', HMM=False)))1 O( m M$ ~4 G

7 I2 s3 L5 f' D' d- p

8 K$ Y8 ?' J% Y! U8 [9 B

【调节词频后】:如果/放到/post/中/将/出错/。+ g0 K; m/ A, d( p

, x! V1 M6 x+ ?0 R& Q5 o+ x( O+ h

4 关键词提取

. N5 P, h7 L& Y. z7 Rjieba 提供了两种关键词提取方法,分别基于 TF-IDF 算法和 TextRank 算法。

' _: A! M6 \5 \) V4 P; W4.1 基于 TF-IDF 算法的关键词提取) O: s4 j2 I' _+ D

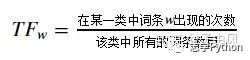

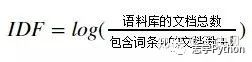

TF-IDF(Term Frequency-Inverse Document Frequency, 词频-逆文件频率)是一种统计方法,用以评估一个词语对于一个文件集或一个语料库中的一份文件的重要程度,其原理可概括为:

( H: g5 A" \7 d1 r* f3 X$ `- T一个词语在一篇文章中出现次数越多,同时在所有文档中出现次数越少,越能够代表该文章2 i# a4 A( b- u" q

/ H: ~' E7 w6 j+ s

计算公式:TF-IDF = TF * IDF,其中:9 f4 W& c& ? K" }; U2 e

通过 jieba.analyse.extract_tags 方法可以基于 TF-IDF 算法进行关键词提取,该方法共有 4 个参数:

3 a+ v# p: x5 c/ Q& k1 B P

- " W! s; z' P; c5 T) o& Y6 i3 m

/ {: [/ z4 Q' \* ]! Y# _

s = "此外,公司拟对全资子公司吉林欧亚置业有限公司增资4.3亿元,增资后,吉林欧亚置业注册资本由7000万元增加到5亿元。吉林欧亚置业主要经营范围为房地产开发及百货零售等业务。目前在建吉林欧亚城市商业综合体项目。2013年,实现营业收入0万元,实现净利润-139.13万元。"6 `% M# M5 D$ {* w2 z7 }' q7 `: ~9 @

( M. F8 g% {+ k g/ ~

$ z: {' N6 q) m9 r0 X- X+ [

6 {; C' ~3 f- M0 c7 i& bfor x, w in anls.extract_tags(s, topK=20, withWeight=True):* B" w" J9 A4 X" e0 S

! b% t4 q4 y7 [) n- @$ ~, K- " k1 m: I& C' |" Z# m

! \, v3 g L! R0 M7 ?7 n! R e5 j

print('%s %s' % (x, w))

5 Y! C# q) \) o

8 U' z. H' k: L5 ^& M% s

' h" b3 x* G0 l+ W K2 U; M

欧亚 0.7300142700289363

+ y! Z9 L% a* M, `吉林 0.659038184373617/ e D( T) @# V' K5 Q; ]8 M! t" D9 G

置业 0.4887134522112766

* @& W7 f- l/ ~+ j4 Q万元 0.33927224818595749 _2 _* @! f- S4 f# I9 c6 x" W

增资 0.33582401985234045

% R4 S2 K% c' V% {4.3 0.25435675538085106

" @% @* }4 M9 a7000 0.25435675538085106( M2 x, A3 ?# e/ U8 b6 F

2013 0.254356755380851060 N: n8 i% c0 C$ O+ d$ h, v

139.13 0.254356755380851061 d0 B3 p5 \8 O, g X

实现 0.19900979900382978

- ]- l# u. P' ?% i& e- d6 W8 q综合体 0.194803096247021277 D4 _& ]% v X! _

经营范围 0.19389757253595744& c! k3 x4 D2 @

亿元 0.1914421623587234

% v$ N- o! j3 X% |6 `在建 0.17541884768425534

Q# U, ?7 U" X4 O) U- l+ ^全资 0.17180164988510638, G. x! ~2 @4 u; Y% A7 E0 V

注册资本 0.1712441526# e7 @+ E) S" z3 P/ U

百货 0.167344600413829797 @' O) r" p: j9 H( i H$ \

零售 0.1475057117057447& }( `# c, J- d. A

子公司 0.145960452377872341 H. X; ]8 `3 b4 q2 Y1 k

营业 0.139201785090212752 [. [: i1 y' _" G, s2 ~/ n

6 g' w9 d& w2 ?! Y/ f% k" T8 i使用 jieba.analyse.TFIDF(idf_path=None) 可以新建 TFIDF 实例,其中 idf_path 为 IDF 频率文件。

0 X5 @" [0 \+ \: I' V5 L3 {/ p& V4.2 基于 TextRank 算法的关键词提取

0 [4 [+ R% s9 M$ z# T9 M* r4 y8 ETextRank 是另一种关键词提取算法,基于大名鼎鼎的 PageRank,其原理可参见论文—— TextRank: Bringing Order into Texts 。3 T: Y2 o# z( e

通过 jieba.analyse.textrank 方法可以使用基于 TextRank 算法的关键词提取,其与 'jieba.analyse.extract_tags' 有一样的参数,但前者默认过滤词性(allowPOS=('ns', 'n', 'vn', 'v'))。+ B6 k& ~# M! \+ D: M4 H, F9 F% K

& X# C1 g' {' x8 ? O1 c. E% v. e$ y- d- D8 \

* z% n! Q7 ^9 a8 B# G6 ]9 g# g

; j6 q+ |9 ?/ g8 w/ V0 S& _/ Ofor x, w in anls.textrank(s, withWeight=True):

+ ^$ H. k1 \7 U) E+ s+ m' j( o! O. P# c+ A4 t& H6 c+ k

9 x! {+ q: J% N7 U1 F, O4 k) d5 U' Q+ n3 t

print('%s %s' % (x, w))

7 `9 S3 X/ g% g4 h5 O/ W$ P

( X \. o1 F( h/ W2 Y/ e

( I5 |: ~# ?3 Q

吉林 1.0

: w5 v* ~8 ~" h( O4 H欧亚 0.9966893354178172

) ]- O7 d# W, F置业 0.6434360313092776+ i& D: W5 ~# H$ d6 N. x1 M

实现 0.58986066928596262 |# R. d& ]) V

收入 0.43677859947991454

) c: a% \) z) B2 B增资 0.4099900531283276

) r& j. ]4 \" l4 T7 l3 n6 A7 n0 w子公司 0.35678295947672795

9 H& ? `4 a/ S* s `城市 0.34971383667403655

8 }# d( @' \$ n+ W! H3 g+ v商业 0.34817220716026936

0 {9 `0 q8 |- m9 R3 `6 L7 N业务 0.3092230992619838

% C( `* q4 D& j! ?在建 0.3077929164033088

7 p+ E( y E% r& h7 [: `营业 0.3035777049319588, {; v! U5 g- N& E, L( J

全资 0.3035409810534757 U+ e# N% T; I$ \3 `& P

综合体 0.29580869172394825! ^4 P( I: H y

注册资本 0.29000519464085045

% D5 ^! s3 _$ ~; c- L' g# G有限公司 0.2807830798576574* \4 d0 \* E6 g2 v" H& [

零售 0.27883620861218145

0 `" a N7 t/ k, @) x$ m8 c p$ R. H百货 0.2781657628445476

1 L/ c. a+ A* a/ z开发 0.2693488779295851

) t2 _; r2 W) E. {经营范围 0.2642762173558316. n) M- N Q _ |6 K4 h

+ B8 O* ~ ~, E' Q4 W使用 jieba.analyse.TextRank() 可以新建自定义 TextRank 实例。

2 I2 r3 p; m1 c; y2 Q4.3 自定义语料库0 X. U# v1 V% `( Q. i8 G$ ^

关键词提取所使用逆向文件频率(IDF)文本语料库和停止词(Stop Words)文本语料库可以切换成自定义语料库的路径。* ?% j8 H; m$ {4 x! ]( w* D; o$ H

/ p0 a2 D3 k" @* ?- @+ c) d# v% W# g

?# E `! \4 X' o

! A! N2 g1 o- a* d# f( \& I$ A5 i! Z. n- I# d

jieba.analyse.set_stop_words("stop_words.txt")

6 P2 X4 I& {6 K# E; W# C9 q$ z

1 ?5 v# M9 {. w/ p+ u) W

$ N# ]: c' n8 n2 }% G! O& [3 V9 ]' V$ \

jieba.analyse.set_idf_path("idf.txt.big");/ ?- q) X, v% Z3 \9 J B

" }' \* V9 X- E Y) p& r2 M

9 n- z$ g6 L' o) \" t/ l5 V! U' w8 r3 c: o8 B

for x, w in anls.extract_tags(s, topK=20, withWeight=True):

' Z* {+ @: I. f$ e

9 Q2 [+ w( T9 `5 {% i" @! e

3 c, \% ]2 Q9 S% K1 E1 E

: H- O1 C0 d9 \" k" w; t4 R; O8 F print('%s %s' % (x, w)); f+ t6 L! c+ Z M

" p0 n/ e* @1 N/ ]# Q; B) ^. `& [

4 X7 P( Z8 f2 O9 X6 _; |

吉林 1.0174270215234043. J0 l* W- Z1 {; t- _8 |1 E y

欧亚 0.73001427002893633 c) k. w" N; F# q& i y: }

增资 0.5087135107617021

" o+ F. `6 t5 [8 g1 j1 W. R. I实现 0.5087135107617021; U: x. v# f! |6 s+ I: C7 a

置业 0.4887134522112766

& v9 L% i8 ?4 d4 u万元 0.3392722481859574

/ g- h& p" f$ g$ T此外 0.25435675538085106% h1 t+ `1 e& J$ v$ x, I

全资 0.25435675538085106

6 f2 x- n2 J4 F! H) p. Q* W# R有限公司 0.25435675538085106

1 x7 L" D h1 S) L2 P" j4.3 0.254356755380851062 ` U# Y: h# f* M, I

注册资本 0.25435675538085106

! P, f, f$ g0 G5 o) I9 ?, R7000 0.25435675538085106

{* m3 @0 H7 t/ p, l1 p增加 0.25435675538085106 |$ V" `! {' r0 ^

主要 0.25435675538085106% [$ v! ?0 L: S

房地产 0.25435675538085106

- Q+ M j$ E: Q& O# R c业务 0.25435675538085106

7 s" g% F. g$ l/ e0 [' M目前 0.25435675538085106

% K1 Q2 K$ Y$ j1 K5 ?! i城市 0.25435675538085106

/ Y# y/ l1 }% ^; F/ X综合体 0.25435675538085106

% o. x! j' n6 O% l4 s3 _! D: ~0 M0 E2013 0.25435675538085106

3 d. k! Z5 l1 L7 `$ d0 k2 g( w% l. b3 q/ P

( p/ H& Y1 C5 t( E4 @$ T; g% T' i5 词性标注

! e. s2 i5 R2 }2 K4 K: p( G1 Y5 ]% qjieba.posseg.POSTokenizer(tokenizer=None) 新建自定义分词器,tokenizer 参数可指定内部使用的 jieba.Tokenizer 分词器。jieba.posseg.dt 为默认词性标注分词器。, h: K* S. f% l% N% e

# 标注句子分词后每个词的词性,采用和 ictclas 兼容的标记法。

# i- X" {1 O( C+ \# N1 R) _$ S- w+ O5 ~

$ [+ j4 v) H& O, a! Y/ w

4 \3 {5 ]6 A; J* V$ O# \ p% i* Q7 E3 C! l

words = pseg.cut("他改变了中国")0 B N7 p6 S/ h1 C

% x" D5 q+ F' i/ V; c4 H( {9 o5 _

& m6 q5 a9 W2 l8 _8 a3 S' p7 X

* ?3 S( E# C8 k: f/ y! ~for word, flag in words:

- d6 P! j# i2 m" Q0 y- I

x" T* L, m+ ~5 A

+ x$ n: g r: D* n, ]1 T. g/ k; `3 _: z5 M0 a& ~

print("{0} {1}".format(word, flag))

2 `2 [6 d/ ^ e( p# B, C" p; j8 ]( S2 M

( d, J& k$ k+ g9 ^# C; F' ~* Q

他 r

改变 v

了 ul

中国 ns

6 并行分词

& Q) T- e6 K9 _! S4 H将目标文本按行分隔后,把各行文本分配到多个 Python 进程并行分词,然后归并结果,从而获得分词速度的可观提升。用法:: _( K9 f" v6 c5 H. v8 O; a

# 可参考 test_file.py0 v: {( q* x& o! |

注意:基于 python 自带的 multiprocessing 模块,目前暂不支持 Windows

9 [7 @4 A# s8 R

* s! ^2 k9 O, D7 O% x% U( o, W: V9 c, v' i9 ~

7 返回词语在原文的起止位置

使用 jieba.tokenize 方法可以返回词语在原文的起止位置。

注意:输入参数只接受 unicode

- : Z4 r E0 e) Z/ C: l1 A( t1 ~6 t

8 \3 }* }, C/ N, Cresult = jieba.tokenize(u'上海益民食品一厂有限公司')

c s8 m, ~ Y& ]/ r# K

- @5 O5 @/ m! D; o7 V) G

" A4 ^7 N6 q3 t1 j! i2 w! p( P" X5 h

print("【普通模式】")/ m3 d! ^, S' X

h1 V, A! b1 @

9 {- p9 ]$ {3 B' P$ _5 k8 I p+ I/ Q* `

for tk in result:3 J2 X- O) _' o- H! \

! G; J+ V0 G0 c3 g

6 d9 A+ D! V& R, F3 \8 T' Q0 ]

$ G% g1 ?- C( g print("word: {0} \t\t start: {1} \t\t end: {2}".format(tk[0],tk[1],tk[2]))2 B2 n% X6 Y! q

' ?& R( k8 \: [% z

/ A0 }9 |6 h2 {+ |; z# K6 \9 m

【普通模式】( X# K, H9 x0 a

word: 上海 start: 0 end: 2

! `% B9 V+ R- o$ f6 wword: 益民 start: 2 end: 4

* H+ d6 e! E; T8 b$ T: ^1 `word: 食品 start: 4 end: 6

8 {, @$ g% D: w8 Z/ q V7 H* t" Qword: 一厂 start: 6 end: 8

0 F0 s, F% J, `9 w: S0 I8 k: nword: 有限公司 start: 8 end: 129 i# z/ q( o1 x% n# [& v: r$ W/ ^

7 H; M. R* Y7 [+ k

0 X3 B# l- x9 P! Q& }/ o& q- h

}* L: G$ i7 I5 N) L# x0 ?. L

|4 Q1 s* x# g% tresult = jieba.tokenize(u'上海益民食品一厂有限公司', mode='search')

. O. J4 q* Q* N/ C [5 e L- L

. Y1 E7 L- }) `9 z Z2 C/ g& Q

& w# G8 N- }- U: @+ [3 p/ _! A+ i% H1 D" j

print("【搜索模式】")

' r7 G7 I! {, `: b. ^" o% k1 x' t$ h; g: ]4 \

- 0 a H: T( X; U1 g' }

3 {2 b$ o7 _: A/ Z8 [" efor tk in result:

: V) J/ }9 W0 w. D, M- y$ x8 Z9 Z5 @/ r# s: u' P1 H2 O

2 j) h; R k4 Y8 z

& ~+ w4 J3 ^0 B9 R: r7 _ print("word: {0} \t\t start: {1} \t\t end: {2}".format(tk[0],tk[1],tk[2])); { u% E/ c k" j2 L4 G( n

7 z" k- C. S% I, P4 E& }+ b5 n0 U

【搜索模式】' b9 k9 C/ a; U! O( B8 A) \

word: 上海 start: 0 end: 2

" F8 Q9 q. P+ K7 dword: 益民 start: 2 end: 45 d3 k7 S U7 j" c8 [

word: 食品 start: 4 end: 6

6 n/ V0 \" i& X; p- Cword: 一厂 start: 6 end: 8

$ Y& t B/ N- i; g2 J$ J8 T" p Bword: 有限 start: 8 end: 10

; {9 v1 G- p: j- gword: 公司 start: 10 end: 129 ^% D" H* o- A( F% @

word: 有限公司 start: 8 end: 12

z6 E" B+ L6 u% t4 k

; w- V* X) u. g5 E* C

| 欢迎光临 数学建模社区-数学中国 (http://www.madio.net/) |

Powered by Discuz! X2.5 |